Mit einem besonderen Experiment beantworten Freiburger Wissenschaftler eine jahrzehntelang diskutierte Forschungsfrage

In Pink ist das artikulatorische Hirnareal abgebildet, das sowohl bei der Produktion als auch bei der Wahrnehmung der Sprache bei allen Probanden aktiv war. Grafik: Translational Neurotechnology Lab (Freiburg)

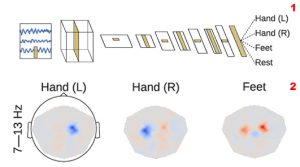

Hirnregionen, die an der Produktion von Sprache beteiligt sind, sind auch bei der Wahrnehmung von Sprache aktiv. Zu diesem Ergebnis kommt ein Team des Exzellenzclusters BrainLinks-BrainTools der Universität Freiburg – und liefert damit einen wesentlichen Beitrag zur Klärung einer jahrzehntelang kontrovers diskutierten Forschungsfrage. Die Wissenschaftlerinnen und Wissenschaftler haben ihre Ergebnisse im Fachjournal „Scientific Reports“ veröffentlicht.

Spontane sprachliche Kommunikation ist ein fundamentaler Teil des sozialen Lebens. Aber was passiert dabei im menschlichen Gehirn? Obwohl die Neurowissenschaft der Sprache in den vergangenen Dekaden dank experimenteller Untersuchungen stetig vorangeschritten ist, ist wenig darüber bekannt, wie Sprache bei nicht-experimentellen, spontanen Bedingungen des Alltags im Gehirn unterstützt wird. Inwiefern die für Artikulation verantwortlichen Gehirnregionen auch bei der Wahrnehmung von Sprache aktiviert werden, ist seit Jahrzehnten umstritten. Manche Forscherinnen und Forscher haben eine solche Aktivierung bei experimentellen Untersuchungen beobachtet und daraus geschlossen, dass es sich um einen Mechanismus handelt, der für die Wahrnehmung von Sprache notwendig ist. Andere haben diese Aktivierung in ihren Experimenten nicht gefunden und daraus abgeleitet, dass sie selten sein muss oder womöglich gar nicht existiert.

Beide Lager waren sich jedoch einig: Wenn sich die Hirnaktivität in artikulationsrelevanten Regionen während der Wahrnehmung von Sprache verändert, könnte dies auch auf den Aufbau des Experiments zurückzuführen sein – schließlich unterscheiden sich experimentelle von spontansprachlichen Bedingungen markant. Deshalb war eine Studie anhand von natürlichen Konversationen notwendig.

Mithilfe eines besonderen Designs ist es den Forschern aus Freiburg gelungen, neuronale Aktivität bei solchen Konversationen zu untersuchen. Dies geschah mithilfe von Aufnahmen von Gehirnaktivität, welche während alltäglicher Unterhaltungen bei neurologischen Patienten zur Diagnostik aufgezeichnet wurden und anschließend mit Einverständnis der Patientinnen und Patienten für Forschung verwertet werden durften. Die Wissenschaftler zeigen, dass artikulationsrelevante Hirnregionen zuverlässige Aktivität bei der Wahrnehmung spontangesprochener Sprache aufweisen. Diese Regionen waren jedoch nicht aktiviert, als die Probanden nicht-sprachliche Geräusche gehört haben.

Originalpublikation:

Olga Glanz (Iljina), Johanna Derix, Rajbir Kaur, Andreas Schulze-Bonhage, Peter Auer, Ad Aertsen, Tonio Ball (2018): Real-life speech production and perception have a shared premotor-cortical substrate. In: Scientific Reports.

https://rdcu.be/VDs2